Une enquête sur les finances de cinq entreprises influentes dans le domaine de l’IA…

La Commission fédérale du commerce (FTC) des États-Unis a annoncé la semaine dernière une enquête sur les finances de cinq entreprises influentes dans le domaine de l’intelligence artificielle (IA), dont sans surprise, Microsoft, afin d’éviter d’éventuelles pratiques anticoncurrentielles.

Alphabet, la société mère de Google, Amazon, Anthropic, Microsoft et OpenAI seront donc étudié de près pas l’organisme américain. La FTC leur a demandé de « fournir des informations sur les investissements et les partenariats récents ». L’enquête se concentre spécifiquement sur les transactions suivantes, selon le communiqué de presse de la FTC :

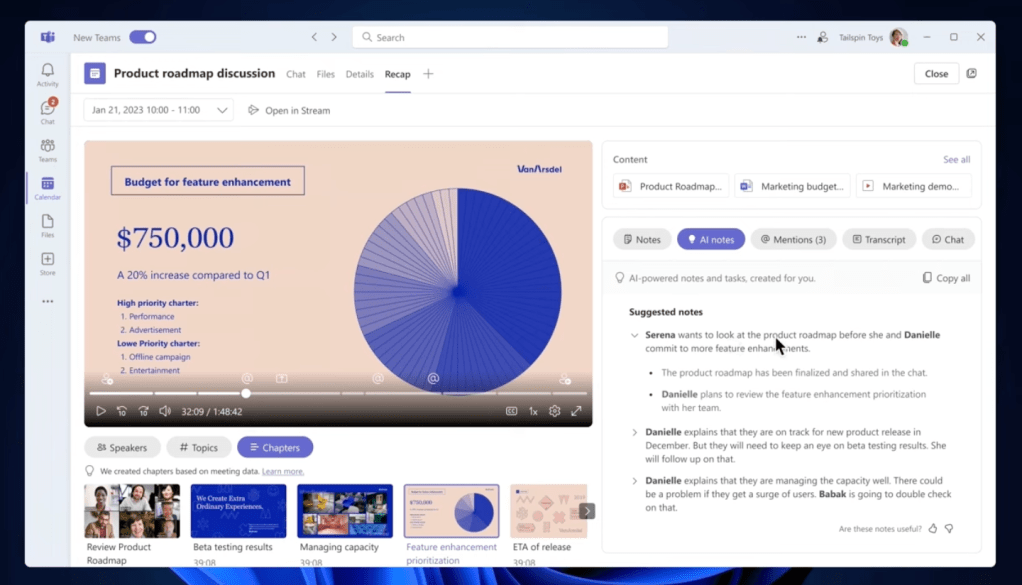

- Les milliards de dollars d’investissements de Microsoft dans OpenAI, le fabricant de ChatGPT , dont il détient une participation minoritaire de 49 %.

- L’investissement de 4 milliards de dollars d’Amazon dans Anthropic, qui lui a permis d’acquérir une participation minoritaire dans le fabricant de chatbots Claude AI.

- Bien sur également Google pour son investissement aussi récent dans Anthropic, histoire de combler les retards de ses technologies maison.

- Ainsi donc que OpenAI et Anthropic…

L’enquête est une première mesure prise par le gouvernement américain pour prévenir l’apparition d’un monopole ou de tout autre problème antitrust sur le marché de l’IA générative.

« L’histoire montre que les nouvelles technologies peuvent créer de nouveaux marchés et une concurrence saine. Alors que les entreprises font la course pour développer et monétiser l’IA, nous devons nous prémunir contre les tactiques qui verrouillent cette opportunité. »

Lina M. Khan, présidente de la FTC

Les entreprises sont invitées à fournir des documents, qui permet à la FTC d’ordonner aux entreprises de fournir des informations sur leurs pratiques commerciales sans qu’une enquête criminelle ne soit nécessaire.

La FTC demande notamment des études sur l’impact de chaque opération sur les parts de marché des participants et sur le marché global de l’intelligence artificielle, des feuilles de route pour les produits, des plans d’embauche et d’affectation du personnel, toute information fournie à des gouvernements extérieurs en rapport avec l’opération, des accords d’exclusivité entre les participants à l’opération, et bien d’autres choses encore.

L’enquête 6, datée du 24 janvier, donne aux entreprises 45 jours pour déposer les informations requises auprès de la FTC. Une copie de la demande peut être consultée ici.