Windows sous ARM sera t-il (enfin) un succès ?

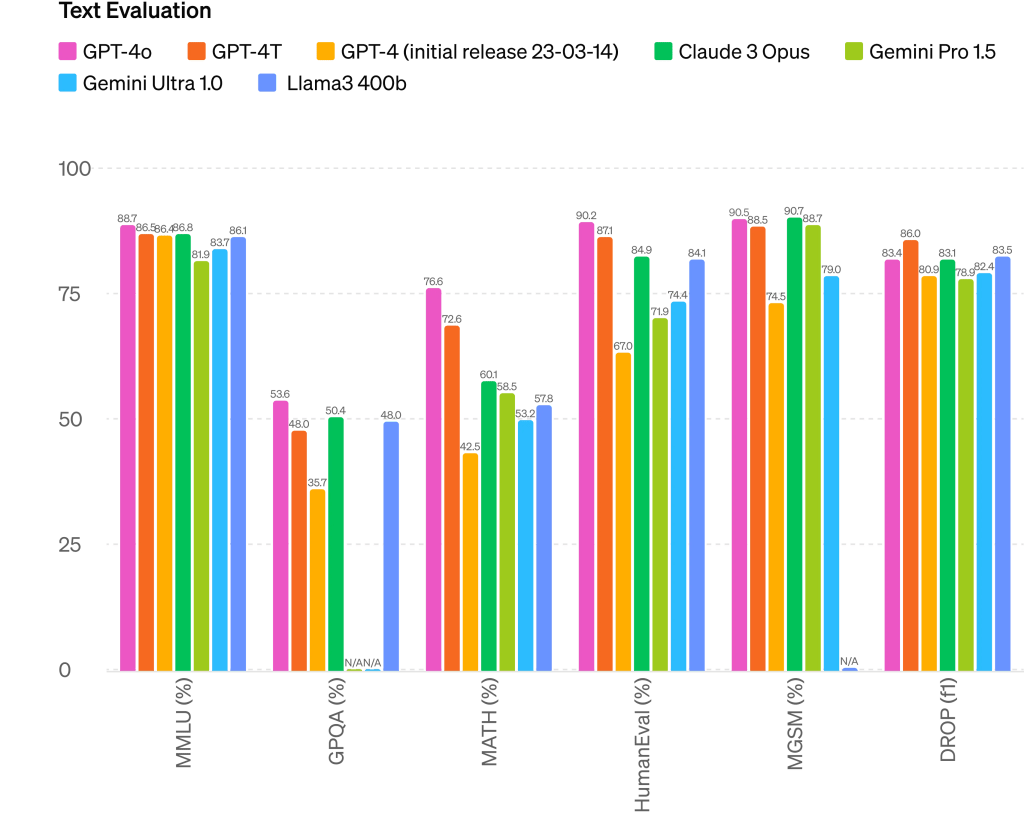

Lors d’un événement précédant d’une journée la Build, Microsoft a dévoilé les PC Copilot+, qui comprennent sa propre ligne mise à jour d’appareils Surface. Microsoft a déclaré que les nouveaux PC, qui proviendront également de partenaires tels que Dell, ASUS, HP et plus encore, et tireront parti de certains des derniers outils d’IA Copilot, tels que Recall, qui conserve une chronologie en cours de vos moindres actions sur les PC spécialement conçus pour aider avec des requêtes personnalisées. Ces PC exécuteront le dernier modèle OpenAI GPT-4o.

Les PC Copilot+ seront dotés d’une nouvelle architecture système qui combine la puissance du CPU, du GPU et d’une unité de traitement neuronal (NPU). Ces composants, améliorés par de grands modèles de langage (LLM) fonctionnant dans Azure Cloud, permettent aux PC Copilot+ d’atteindre ce que l’entreprise affirme être « jusqu’à 20 fois plus puissant et jusqu’à 100 fois plus efficace pour exécuter des charges de travail d’IA et fournir une accélération de l’IA à la pointe de l’industrie », par rapport aux PC actuels. Mais surtout l’entreprise entant rivaliser avec les MacBook Air d’Apple en affirmant que ces PC seront 59% plus rapide et 80 % plus rapide que les plus puissante des Surfaces précédentes (de quoi révéler donc officiellement que les MacBook Air était beaucoup plus rapide que les matériels Surface existants au passage…)

Mais la nouveauté la plus importante est bien entendu la mise en oeuvre des puces ARM de Qualcomm en lieu et place des processeurs x86 (qui arriveront plus tard avec un NPU dans l’année selon Microsoft et pourront ainsi recevoir les fonctions Copilot+

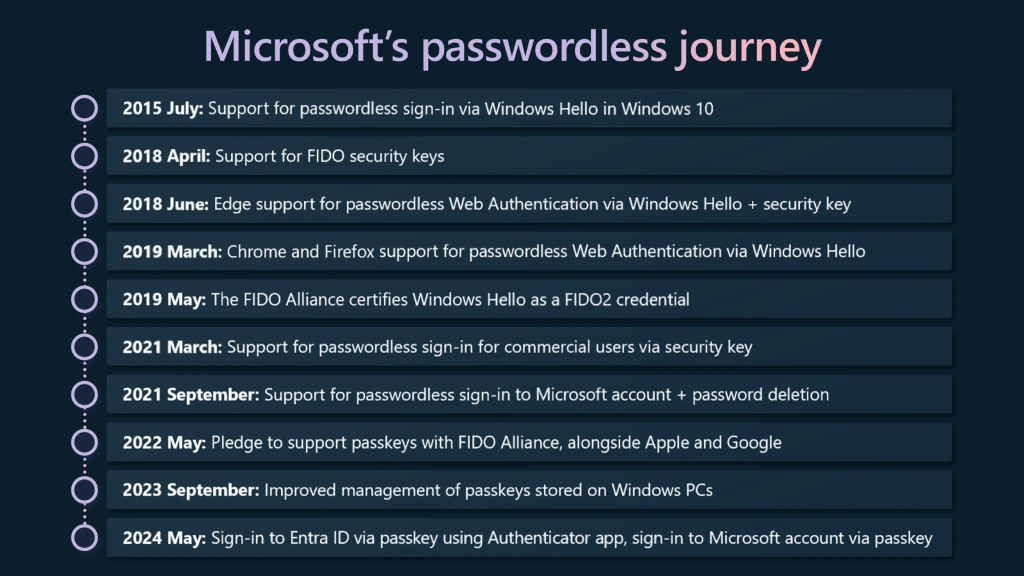

Grâce aux derniers processeurs ARM Snapdragon X, les PC Copilot+ offriraient jusqu’à 22 heures de lecture vidéo locale ou 15 heures de navigation sur le web sur une seule charge. En outre, chaque PC Copilot+ sera livré avec le processeur Microsoft Pluton Security, qui stocke les données sensibles telles que les mots de passe et les clés de cryptage sur la puce elle-même. Équivalent de la puce T2 d’Apple.

Outre la nouvelle fonction « Retrouver » de Copilot, permettant de retrouver tout ce que l’on a fait précédemment sur son PC (les démos étaient très sympa) les nouveaux PC seront également dotés de nombreuses nouvelles fonctions d’intelligence artificielle :

- Cocreator : Générer et affiner des images en temps quasi réel à l’aide d’algorithmes et de curseurs de créativité.

- Restyle Image : Réimaginez vos photos personnelles avec de nouveaux styles et modifiez les images à l’aide d’outils alimentés par l’IA dans Photos.

- Sous-titres en direct : Traduisez n’importe quel fichier audio en sous-titres anglais en temps réel dans toutes les applications.

Parallèlement au dévoilement de la nouvelle gamme de PC Copilot+, Microsoft a annoncé que les premiers appareils à arriver seront ses nouveaux Surface Pro 11 et Surface Laptop 6, tous deux à partir de 1200 €. La nouvelle Surface Pro sera disponible avec le processeur Snapdragon X Elite ou X Plus, la connectivité 5G en option et un choix entre un écran IPS ou OLED. Le prochain modèle d’ordinateur portable Surface sera également livré avec les puces Snapdragon Elite ou Plus. Les utilisateurs peuvent configurer l’appareil avec jusqu’à 64 Go de mémoire et 1 To de stockage SSD. Les deux appareils seront disponibles le 18 juin aux USA et en France et peuvent être précommandés dès maintenant sur le store Microsoft.

L’événement d’aujourd’hui a également été l’occasion pour des partenaires d’annoncer la sortie prochaine de leurs propres PC Copilot+ (avec processeur ARM donc)

- Acer Swift 14 AI

- Asus Vivobook S 15

- Dell XPS 13

- Dell Inspiron 14 Plus

- Dell Inspiron 14

- Dell Latitude 7455

- Dell Latitude 5455

- HP OmniBookX AI

- HP EliteBook Ultra G1q AI

- Lenovo Yoga Slim 7x

- Lenovo ThinkPad T14s Gen 6

- Samsung Galaxy Book4 Edge

Alors Windows sous ARM sera-t-il, après plus de 12 ans de tentative (le premier matériel était la Surface RT) un succès ?

Trois éléments selon nous pour répondre à cette question :

- D’un point de vu marketing, Microsoft a bien joué : l’exclusivité (dans un premier temps) des fonctions Copilot accélérées grace au NPU dans cette gamme est habile. Aujourd’hui le « Copilot » fait vendre et Microsoft le sait si l’on regarde l’emballement atour de Copilot pour M365 par exemple qui constitue un gros plus (nous y reviendrons lors du prochain Briefing Calipia)

- Microsoft aurait affiné son traducteur de code x86 vers ARM, dénommé Prism, il aurait une puissance 20% supérieure à la version précédente (sans que l’on sache si ceci vient du processeur ou du logiciel).

- Reste l’épineuse question des logiciels Natifs. L’entreprise arrivera-t-elle enfin à convaincre les développeurs de développer sur code Windows ARM ? A commencer par les développeurs internes chez Microsoft qui n’ont par exemple côté Office aucun mal à porter ce dernier sur les puces Apple mais rechignent depuis plus de 10 ans à faire la même chose pour Windows ? De ce côté, nous sommes restés sur notre faim lors de ces annonces avec aucune date précise de dispo (y compris coté Adobe)…

Il faudra donc attendre un peu pour voir si la mayonnaise prend enfin pour ces machines très séduisantes au moins sur le papier. Avec on l’espère, enfin des logiciels natifs et des Benchmarks indépendants qui confirmeront (ou pas) les performances (Qualcomm par le passé était assez enthousiaste avec ses processeurs au moment des annonces… un peu moins sur les tests réels). Enfin tout dépendra aussi de la réponse d’Intel (on parle du 3ème trimestre) pour voir si un fois de plus les clients ne choisirons pas la sécurité en reprenant de l’x86, valeur sure, disposant du label Copilot+ également…

Nous en reparlerons lors du prochain Briefing Calipia bien évidemment.