[Ignite] De nombreuses autres annonces Azure et IA

Microsoft rend disponible à partir d’aujourd’hui son système Azure Boost conçu pour accélérer le stockage et la mise en réseau en déplaçant des processus de serveurs hôtes vers du matériel et des logiciels personnalisés. Il prévoit également d’ajouter des VM accélérées AMD MI300X à Azure, conçues pour accélérer le traitement IA, et fournit en preview la série de VM NC H100 v5 conçue pour les GPU NVIDIA H100 Tensor Core, destinée à améliorer le Machine Learning et l’inférence.

Satya Nadella est aussi revenu hier sur le rachat de la startup anglaise Lumenisity (en 2022) qui travaillait sur une nouvelle forme de fibre optique, appelée « hollow core », conçue pour améliorer les vitesses de transfert de données sur de longues distances. En 2023, elle a acheté une autre startup acteur, Fungible, qui développait des unités de traitement de données (DPU) pouvant être utilisée pour une variété d’améliorations de cartes d’interface de réseau. Aujourd’hui ces technologies sont en cours de mise en oeuvre dans Azure afin d’amélioré globalement la disponibilité des système. Le PDG de l’entreprise parle de gains pouvant atteindre les 40%, sans plus de précision.

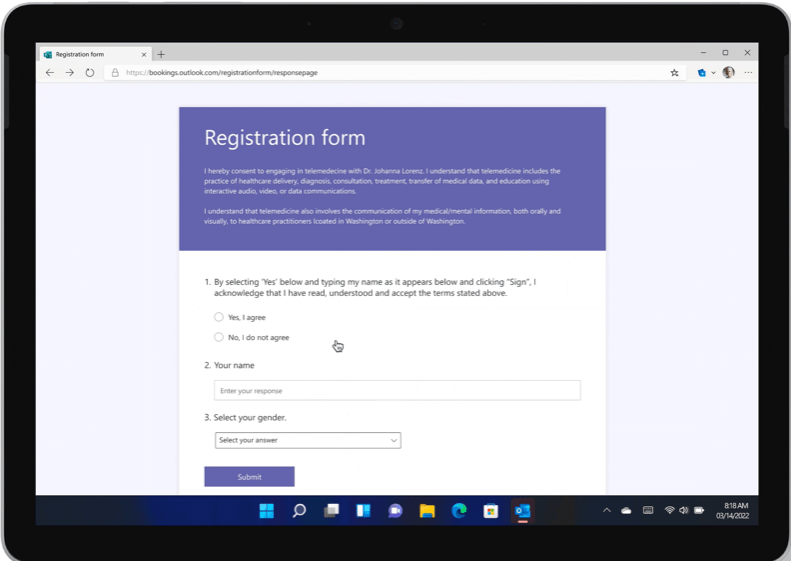

En mai dernier lors de la Build, Microsoft avait annoncé Azure AI Studio, elle a indiquée hier soir que cet outil était maintenant dispo en beta publique. Azure AI Studio fournit une interface utilisateur pour aider à créer des chats personnalisés et compatibles avec l’IA, y compris l’amélioration du chat avec des données organisationnelles.

L’entreprise à également annoncée hier : Windows AI Studio, un produit complémentaire qui devrait être disponible dans les semaines à venir, permettra aux développeurs d’exécuter leurs modèles d’IA dans Azure, mais aussi localement (sur Windows).