#CES2026 Conférence Nvidia : une petit résumé critique :)

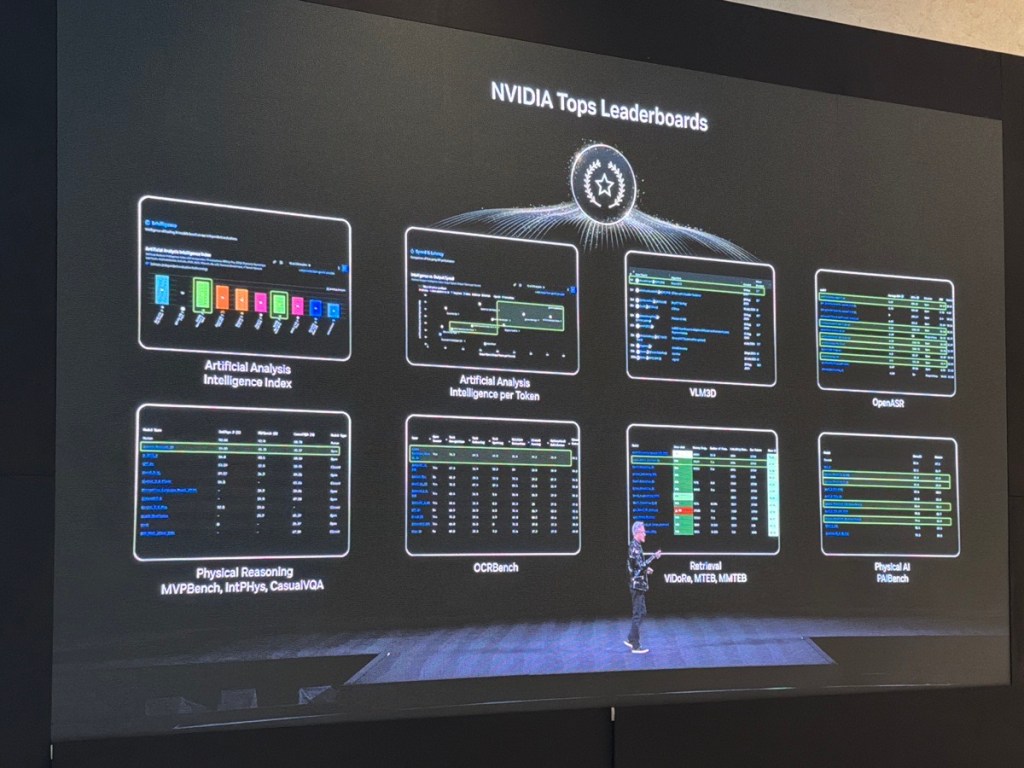

Nous étions hier après midi à la conférence de lancement de l’année d’Nidia. NVIDIA a frappé fort — encore. Avec le lancement officiel de Rubin, sa nouvelle plateforme IA de bout en bout, le leader incontesté ambitionne désormais de redessiner l’architecture même de l’intelligence artificielle, depuis le silicium jusqu’aux API cloud. Et Microsoft, partenaire stratégique, est déjà dans les starting-blocks pour déployer Rubin dans Azure. Petit tour d’horizon — critique — de cette nouvelle étape dans la consolidation technologique de l’IA.

Rubin : une plateforme, pas une puce

Contrairement aux apparences (et au jargon marketing), Rubin n’est pas seulement une nouvelle génération de GPU. C’est un écosystème complet qui agrège matériel, logiciels et interconnexions réseau dans une approche intégrée — certains diront verrouillée.

Composants clés :

- GPU Rubin : gravés en 3 nm, successeurs des Hopper/Blackwell, avec une architecture optimisée pour le traitement de grands modèles de fondation.

- CPU Vera : basés sur ARM, orientés efficacité énergétique et forte densité.

- Interconnexions NVLink et NVSwitch nouvelle génération : bande passante doublée, latence réduite, pour soutenir les besoins massifs en mémoire des LLM.

- Plateforme logicielle NVIDIA AI Enterprise (mise à jour) : Rubin y est évidemment intégré, avec un support natif pour l’exécution de modèles multilingues, multimodaux, et distribués.

Microsoft annonçait juste après la conf que Rubin sera intégré à Azure dès fin 2026. Une preuve de confiance, ou un signe que les hyperscalers n’ont plus le choix ? En réalité, cette dépendance croissante à l’égard de NVIDIA pose des questions fondamentales pour les DSI à mon avis entre Opportunité ou dépendance :

- + Accélération des déploiements IA (serveurs Rubin préconfigurés, interopérabilité CUDA)

- – Verrouillage technologique (CUDA reste central, malgré les appels à l’open source) et le fait qu’Nvidia ne parle que d’Open Source pour les modèles… mais pas pour CUDA 🙂

- – Impact sur la souveraineté numérique (cf. initiatives européennes type EPI ou SiPearl)

Une approche assez monolithique de l’IA ?

Avec Rubin, NVIDIA ne se contente plus de vendre des composants. Elle vend un paradigme. L’idée est claire : faire de Rubin une “AI factory” où l’on peut entraîner, affiner, déployer et monitorer des modèles, sans jamais quitter l’écosystème NVIDIA. Un peu comme si Intel avait lancé Windows à la naissance du cloud. donc en gros, pour les entreprises qui cherchent à bâtir des architectures hybrides ou multi-cloud, Rubin complexifie les choix. Sauf à tout standardiser sur NVIDIA, ce qui revient à dire adieu à toute forme de portabilité des charges IA.

Quid de la concurrence ?

AMD accélère avec ses puces MI300X, mais reste en retrait sur l’écosystème logiciel. Intel mise sur Gaudi 3, mais les benchmarks sont encore confidentiels. Google pousse son TPU v6, mais uniquement dans GCP. NVIDIA, avec Rubin, réussit à fusionner verticalement tous les maillons de la chaîne IA, ce que peu d’acteurs peuvent envisager à cette échelle.

Pour les DSI : vigilance, mais pas rejet

Faut-il sauter sur Rubin ? Pas forcément. Il faudra évaluer :

- Les coûts réels de migration (CUDA vs alternatives type ROCm ou OpenXLA)

- La capacité à maintenir une architecture flexible

- La gouvernance des données et modèles dans des plateformes de plus en plus opaques

Mais surtout, il faut éviter le “GPU lock-in” qui pourrait s’avérer aussi coûteux à long terme que les erreurs de choix de cloud d’il y a 10 ans.

En conclusion

Avec Rubin, NVIDIA poursuit sa stratégie de domination du monde IA, en intégrant hardware, software et services dans un tout cohérent — et redoutablement efficace. Si l’innovation est indéniable, la concentration de pouvoir technologique qu’elle implique doit inciter les entreprises à réfléchir à deux fois avant de céder à la tentation de la simplicité clé en main. Parce que si tout est Rubin, qui contrôle vraiment l’IA ?