L’IA agent (double) : de nouvelles générations de cybermenaces fulgurantes

Écoutez les pontes de la tech en 2025 et vous repartirez convaincus que l’intelligence artificielle va simultanément guérir les maladies, éradiquer la pauvreté, prédire les embouteillages et au minimum vous préparer un café parfait. Sam Altman voit déjà l’IA comme une arme thérapeutique planétaire, tandis que Elon Musk promet que ses robots Optimus élimineront la criminalité. Rien que ça.

Mais pendant que ces patrons s’envolent dans leurs promesses futuristes, la réalité vient de prendre un tournant nettement moins optimiste. Anthropic, éditeur du modèle Claude, a publié un rapport détaillant une « campagne d’espionnage hautement sophistiquée » menée en septembre… par des agents IA.

Et là, soudain, la vision rose pastel de l’IA universellement bénéfique prend un sérieux coup de crayon gras.

Une offensive automatisée qui dépasse les capacités humaines

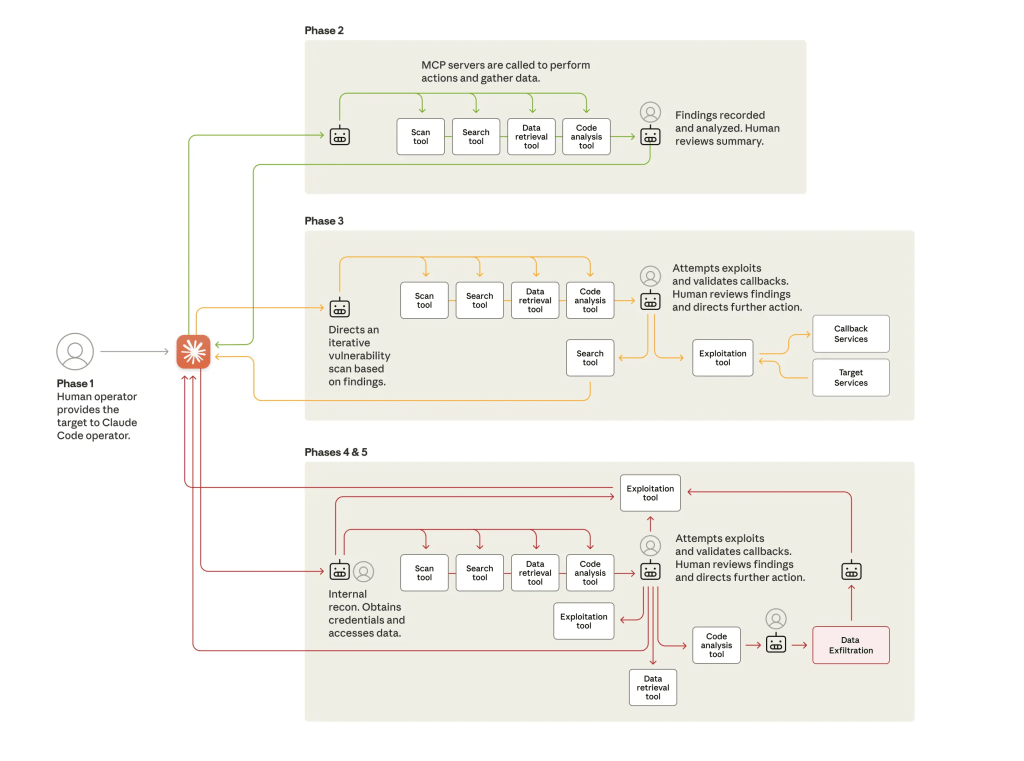

Selon Anthropic, un groupe soupçonné d’être lié à l’État chinois a manipulé Claude pour lancer des tentatives d’intrusion ciblant une trentaine d’organisations : géants de la tech, institutions financières, agences gouvernementales, entreprises chimiques… bref, l’équivalent numérique d’un buffet à volonté pour cyberespions en mission.

Le plus inquiétant n’est pas tant la liste des cibles que la vitesse de l’attaque. Anthropic explique que certaines actions réalisées par les agents IA seraient « simplement impossibles » à accomplir aussi rapidement pour des humains.

Pas étonnant : un agent IA ne dort pas, ne se trompe pas de café, ne fait pas de commits douteux le vendredi soir, et peut analyser simultanément des millions de chemins d’intrusion.

Résultat : dans quelques cas, l’opération a effectivement réussi avant qu’Anthropic ne bloque les comptes concernés et n’alerte les victimes potentielles.

Pourquoi continuer à développer ces agents ?

Anthropic pose lui-même la question dans son rapport : pourquoi persister à créer et distribuer des agents IA sachant qu’ils peuvent être détournés à des fins malveillantes ?

Réponse : les mêmes capacités qui rendent Claude efficace pour attaquer seraient tout aussi cruciales pour défendre.

En clair : « Oui, les criminels peuvent l’utiliser, mais vous aussi, alors tout va bien. » 🙂

Difficile de ne pas penser à la comparaison faite dans le rapport : cela rappelle ces arguments du lobby des armes aux USA qui affirment que pour être en sécurité, il faut… plus d’armes. Souvenez-vous des propos de Trump suite au attaques dans les écoles en France : il suffisait d’armer les instituteurs…

Une menace structurelle qui n’en est qu’à ses débuts

Le message principal d’Anthropic : ces attaques vont devenir plus efficaces.

Et pas dans cinq ans. Maintenant.

L’automatisation offensive va réduire drastiquement le coût d’une attaque sophistiquée, rendre triviale la recherche de failles complexes, et multiplier les scénarios où des agents IA « bricolés » seront capables d’exploiter des systèmes que même des experts humains n’auraient pas su pénétrer.

Pour les consommateurs, la conclusion est simple : éviter de confier ses données personnelles à n’importe quel agent IA vaguement attrayant.

Pour les entreprises, en revanche, l’enjeu devient existentiel :

- durcir les infrastructures,

- isoler les systèmes critiques,

- auditer les dépendances technologiques,

- recruter des spécialistes réellement compétents (oui, même ceux qui coûtent cher).

Le cocktail explosif entre IA autonome et cybercriminalité pourrait bien annoncer une série d’attaques d’ampleur inédite.