Le DGX Spark arrive enfin : NVIDIA met un supercalculateur IA sur votre bureau

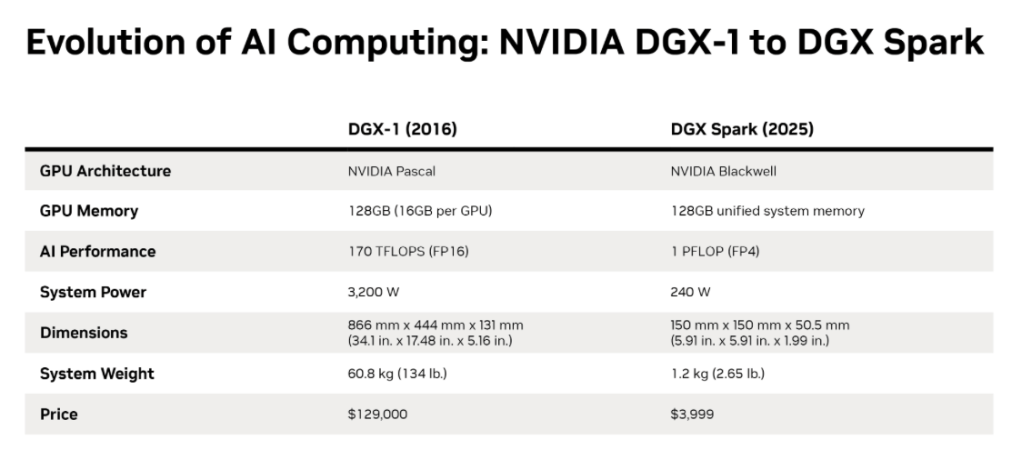

En 2016, Jensen Huang livrait lui-même le tout premier DGX-1 à un certain Elon Musk, alors cofondateur d’une jeune pousse nommée OpenAI. De cette machine naquit ChatGPT, et avec lui l’ère moderne de l’intelligence artificielle. Neuf ans plus tard, NVIDIA reprend le flambeau — littéralement à la main — avec le DGX Spark, une unité de calcul de la taille d’un livre, mais capable de délivrer la puissance d’un supercalculateur.

Présenté initialement au CES sous le nom de code Project Digits, nous avions suivi l’annonce dans la salle et nous vous en parlions sur le blog, ce système débarque désormais sous sa forme commerciale. NVIDIA annonce le début des livraisons pour les clients ayant précommandé et l’ouverture des commandes à partir du 15 octobre 2025.

Une puissance d’un petaflop… dans 1,2 kg d’aluminium

Derrière ses dimensions modestes (15 × 15 × 5 cm) et son poids plume de 1,2 kg, le DGX Spark aligne des caractéristiques qui feraient rougir bien des clusters en datacenter. Son cœur bat au rythme du GB10 Grace Blackwell Superchip, la dernière génération de puces de NVIDIA combinant CPU Grace et GPU Blackwell dans un même package.

Ajoutez à cela 200 Gb/s de connectivité via ConnectX-7, une interconnexion NVLink-C2C à très faible latence, et surtout 128 Go de mémoire unifiée, et vous obtenez un monstre capable de :

- faire tourner en local des modèles d’inférence jusqu’à 200 milliards de paramètres,

- ou d’affiner des modèles jusqu’à 70 milliards de paramètres, sans passer par le cloud.

Autrement dit, ce petit cube ouvre la voie à un retour de la puissance IA sur site, une tendance que nombre de DSI regardent avec intérêt à l’heure où la souveraineté des données et les coûts d’usage du cloud deviennent critiques.

L’écosystème NVIDIA à bord, prêt à l’emploi

Côté logiciel, NVIDIA ne s’est pas contenté de livrer du silicium : le DGX Spark embarque l’intégralité de l’écosystème IA maison. On y retrouve les bibliothèques CUDA et cuDNN, les modèles de référence, les outils de développement comme NVIDIA AI Workbench, et même les microservices NIM (NVIDIA Inference Microservices).

Autrement dit, le développeur n’a plus besoin de passer des jours à configurer un environnement Python, PyTorch ou TensorRT : tout est préinstallé, optimisé et prêt à l’emploi.

Et pour ne rien gâcher, de grands noms de la tech participent déjà à l’aventure. Des acteurs tels que Anaconda, Docker, Hugging Face, JetBrains, LM Studio, Microsoft ou encore Meta adaptent leurs outils au DGX Spark, dans ce qui ressemble fort à une nouvelle norme de station de travail IA.

Vers une démocratisation (très relative) du supercalcul IA

Proposé à 3 000 dollars, le DGX Spark ne vise évidemment pas le grand public, mais il marque une étape décisive : celle de la démocratisation du calcul intensif pour développeurs et chercheurs indépendants.

Là où il fallait hier réserver du temps GPU sur le cloud ou dans un centre HPC, il sera bientôt possible de tester, ajuster et itérer localement avec des modèles massifs.

Pour les entreprises, notamment dans les secteurs régulés (santé, finance, défense), cette approche locale ouvre la voie à de nouveaux cas d’usage :

- fine-tuning de modèles propriétaires sans transfert de données,

- exécution d’agents autonomes internes,

- ou encore entraînement sur jeux de données confidentiels.

Le retour du supercalculateur personnel

Avec le DGX Spark, NVIDIA renoue avec une philosophie presque romantique du calcul : ramener la puissance entre les mains de l’ingénieur. Comme le dit Jensen Huang, « chaque développeur devrait avoir son propre superordinateur ».

Et, soyons honnêtes, qui ne rêverait pas d’un petaflop sur son bureau, histoire de faire tourner son modèle de recommandation caféiné sans priver tout le service IT de bande passante ?

Le DGX Spark est bien plus qu’un produit : c’est une déclaration d’intention. Dans un monde où tout tend vers le cloud, NVIDIA rappelle que l’innovation, elle, commence souvent… hors ligne, dans un bureau encombré de câbles et de prototypes.

Nous en reparlerons au prochain Briefing Calipia