Synthèse Google I/O 2025 : le règne de l’IA omniprésente

Chez Google, 2025 sera l’année du grand glissement tectonique : celui où l’IA n’est plus un outil, mais un substrat. À l’occasion de sa keynote I/O, la firme de Mountain View a dévoilé une série d’annonces qui dessinent un futur où l’utilisateur n’a plus besoin de demander – l’assistant agit avant même que l’intention ne soit formulée. Revenons ici sur les 7 points clés à notre avis de ces annonces.

1. Gemini partout, tout le temps, dans tout

C’est l’axe central de cette édition : Gemini 2.5 (et sa variante allégée, Gemini Flash) s’invite dans Chrome, dans la recherche, dans Gmail, dans le développement logiciel, la création vidéo… jusqu’à vos futures lunettes connectées (nous en parlerons lors du prochain Briefing Calipia avec une sessions dédiée à ces objets). L’IA devient à la fois moteur, interface et compagnon, capable désormais de « penser profondément » avec le mode Deep Think, réservé à quelques privilégiés.

Deep Think, sous ses airs pompeux, cache une fonctionnalité de raisonnement multi-hypothèse, promettant de gérer des requêtes complexes de type mathématiques avancées ou code interprété. On attendra cependant de voir s’il s’agit d’un raisonnement logique ou simplement d’un empilement probabiliste mieux présenté. C’est vrai que les modèles de raisonnements nous ont parfois réservé quelques mauvaises surprises…

2. L’IA dans la recherche : entre promesse et fragmentation

Google introduit AI Mode dans son moteur de recherche, une interface conversationnelle pilotée par Gemini. En théorie, il s’agit d’un passage de la recherche documentaire à l’assistance active : l’utilisateur pose une question, l’IA synthétise le web, propose des tableaux financiers, des fiches produits ou des réponses personnalisées.

Problème : en multipliant les couches d’abstraction (Search, AI Mode, Gemini Live, Lens, Search Live), Google fragmente son propre outil phare. L’utilisateur devra-t-il désormais choisir entre cinq modes pour poser une question simple ? Un nouveau défi UX se profile, mais face à la pression de la concurrence, l’entreprise n’a pas le choix…

3. Project Astra : la proactivité comme horizon

Le prototype Project Astra pousse l’IA proactive à son paroxysme : reconnaissance visuelle contextuelle, réponse orale instantanée, exécution de tâches non sollicitées. Vous pointez votre caméra sur un document, Astra signale une erreur. Est-ce utile ? Certainement. Est-ce contrôlable ? Moins sûr.

Google introduit aussi Search Live, permettant d’interagir avec la recherche en direct via l’appareil photo. Un pas vers une recherche non verbale, mais surtout une mise en tension entre interface naturelle et collecte massive de données en temps réel.

4. Veo, Imagen, Flow : la création visuelle passe à la vitesse AI

Sur le front créatif, Google muscle son écosystème avec Imagen 4 (meilleure gestion du texte dans les images), Veo 3(génération vidéo + audio) et l’application Flow, un outil de création de mini-films à partir de prompts textuels. Ce trio fonctionne en tandem : Veo pour l’action, Imagen pour l’habillage, Gemini pour le récit.

Flow se positionne comme une première tentative d’IA narrative, où l’utilisateur devient metteur en scène par intention. Potentiellement révolutionnaire, à condition de maîtriser les outils de montage contextuel. Mais c’est vrai que les démos étaient clairement bluffantes.

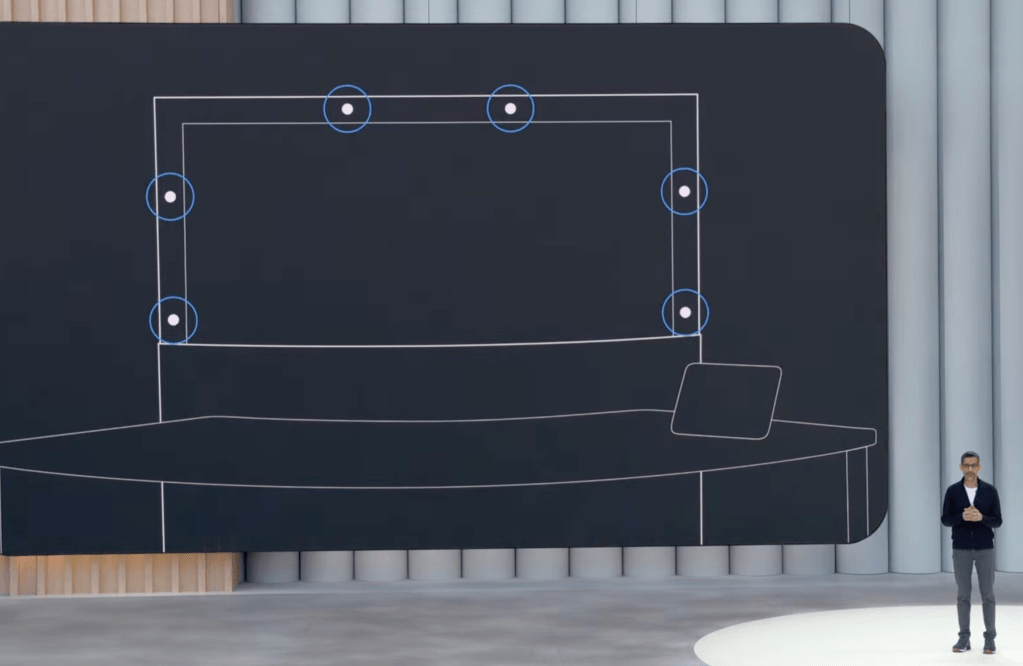

5. Project Starline devient Beam : la visioconférence passe en 3D

Rebaptisé Google Beam, l’ancien Starline devient un dispositif HP intégrant écran à champ lumineux et six caméras pour restituer une image 3D en direct de votre interlocuteur. Objectif : recréer une présence physique, sans casque ni avatar.

Si des entreprises comme Deloitte ou Salesforce l’adoptent, c’est pour son potentiel dans les communications inter-bureaux à forte valeur ajoutée. Reste à savoir si la promesse de présence sera aussi fluide que le marketing le laisse entendre, mais les applications sont nombreuses et permet d’avoir des visios clairement plus convaincantes.

Le matériel sera créé par HP et fonctionnera avec Google Meet et Zoom dans un premier temps.

6. XR et interfaces générées par IA : vers la fusion des mondes

Autre terrain exploré : la réalité étendue. Avec Project Aura, Google s’allie à Xreal pour des lunettes Android XR intégrant Gemini et un large champ de vision. Samsung, Gentle Monster et Warby Parker sont aussi de la partie, signe que l’écosystème XR passe en phase industrielle.

Google en profite pour dévoiler Stitch, un générateur d’interfaces UI à partir de thèmes, maquettes ou croquis. Un pas de plus vers le “no-code designer”, ou la disparition pure et simple du front-end classique dans certains contextes.

7. IA omniprésente, mais à quel prix ?

L’expérience premium a un prix : 250 $ par mois pour l’abonnement AI Ultra, qui donne accès à tous les modèles les plus avancés (Gemini Ultra, Flow, Mariner, etc.), ainsi qu’à des fonctions anticipées. Cela marque une rupture : l’intelligence conversationnelle n’est plus un outil, c’est une plateforme, tarifée comme une solution cloud.

L’IA agentique n’est plus une hypothèse : Gmail écrit désormais des mails à votre place en fouillant votre Drive, Google Meet traduit vos conversations en temps réel, et Chrome va bientôt modifier vos mots de passe compromis automatiquement.

Conclusion : vers un OS invisible ?

Ce Google I/O 2025 acte un basculement stratégique : l’IA devient l’environnement d’exécution par défaut. Une interface vocale et visuelle, un agent multi-média et multi-contextuel. Pour les DSI, cela signifie deux choses :

- Une redéfinition de l’interface homme-machine, où l’OS n’est plus local mais distribué à travers services et assistants.

- Un nouvel enjeu de gouvernance des flux IA, car chaque interaction devient potentiellement une donnée analysée, enrichie, exploitée.

C’est fascinant, certes. Mais entre fascination technologique et dépendance structurelle, il n’y a qu’un prompt de distance.